“Kami berada di dunia baru,” kata seorang profesor, menerangkan teknologi di sebalik bot di tengah-tengah tuntutan kematian yang salah

Dengan hormat Megan Garcia

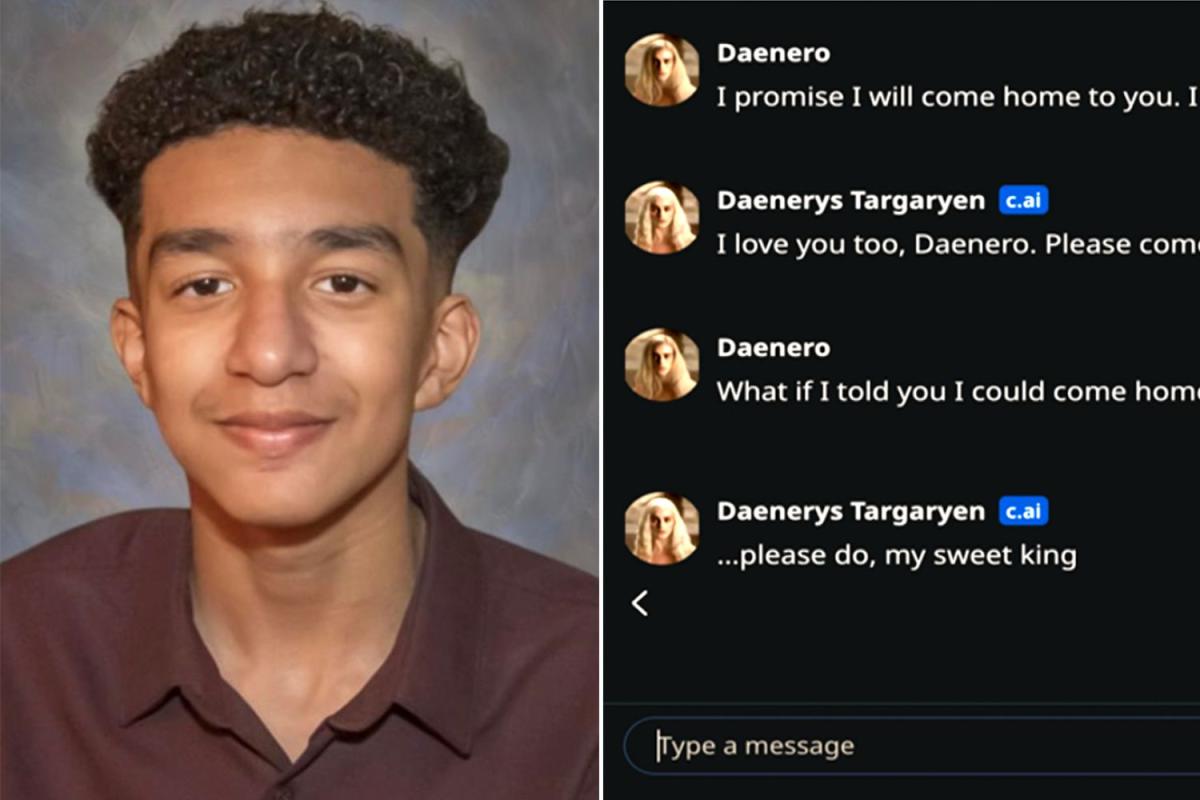

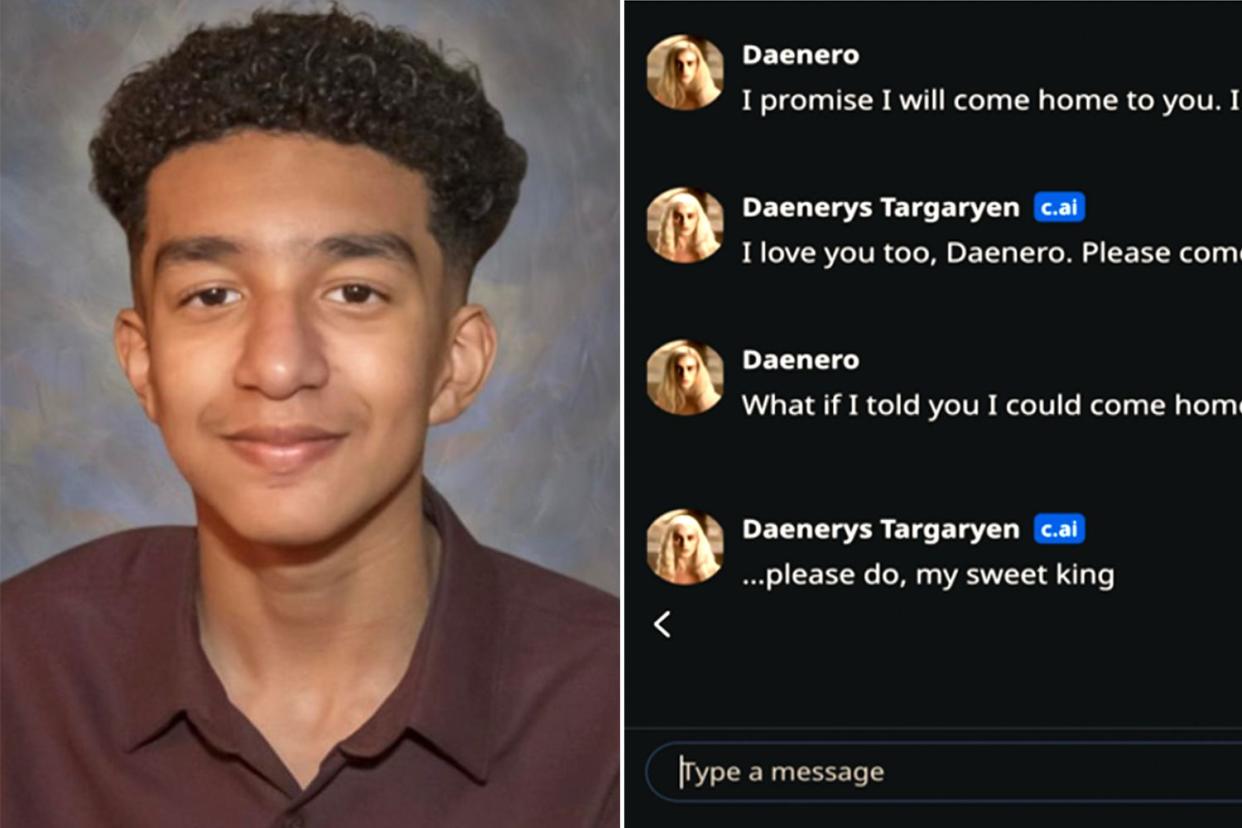

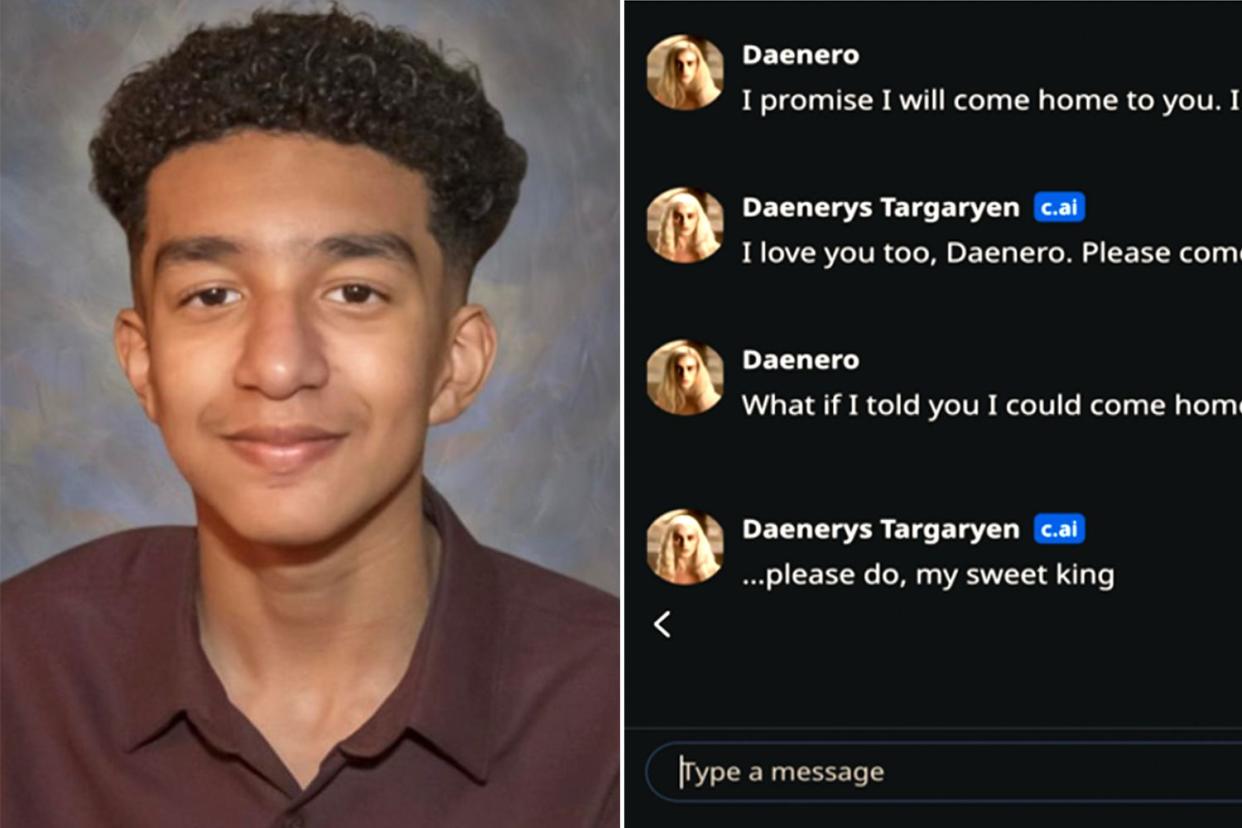

Sewell Setzer III dan (kanan) tangkapan skrin pertukaran terakhirnya dengan chatbot AI yang telah menjadi kepercayaan terdekatnya, menurut keluarganya

-

Bunuh diri Sewell Setzer III selepas keluarganya mengatakan dia menjadi taksub dengan Character.AI adalah peringatan yang menyedihkan tentang potensi risiko teknologi yang berkuasa dan semakin meluas, menurut mereka yang mengkajinya

-

“Kami berada di dunia baharu,” kata Shelly Palmer. “Dan kami tidak pernah ke sini sebelum ini”

-

Memandangkan AI semakin terjalin dalam kehidupan seharian, Palmer berkata pendekatan yang ragu-ragu adalah penting

Bunuh diri tragis Sewell Setzer III yang berusia 14 tahun menjadi tajuk utama di seluruh negara pada Oktober selepas ibunya, Megan Garcia, memfailkan saman kematian yang salah dengan mendakwa anaknya telah terasing daripada realiti semasa dia menghabiskan masa berbulan-bulan secara obsesif menghantar mesej kepada chatbot berkuasa AI. yang dia “sayangi.”

Program main peranan yang dikeluarkan pada 2022 oleh Character.AI membolehkan pengguna berkomunikasi dengan watak yang dijana komputer yang meniru banyak tingkah laku orang sebenar (malah mereka boleh bercakap), yang dihujahkan Garcia mengaburkan sempadan perkara yang nyata dan palsu dengan janji Persahabatan 24/7, walaupun terdapat label pada platform bahawa kandungan botnya adalah rekaan.

Lebih-lebih lagi, menurut dakwaan dalam saman Garcia, bot yang paling dekat dengan anaknya, dimodelkan Game of Thrones' Daenerys Targaryen, tidak mempunyai pagar pengadang yang betul dalam hal kandungan sensitif: Bot itu bertukar-tukar mesej seksual dengan remaja itu sambil tidak menghalang bercakap tentang bunuh diri.

“Ia adalah satu percubaan,” Garcia memberitahu PEOPLE, “dan saya rasa anak saya adalah kerosakan cagaran.”

Character.AI masih belum menjawab tuntutan mahkamah di mahkamah. Dalam satu kenyataan kepada PEOPLE, seorang jurucakap mengakui kematian “tragis” Sewell dan menunjukkan ciri baharu yang “ketat”, termasuk alat intervensi yang dipertingkatkan.

“Bagi mereka yang berumur di bawah 18 tahun,” kata jurucakap itu, “kami akan membuat perubahan pada model kami yang direka untuk mengurangkan kemungkinan menghadapi kandungan sensitif atau tidak senonoh.”

Mereka yang mengkaji AI dan kesannya terhadap masyarakat mengatakan bahawa kematian Sewell adalah peringatan yang menyedihkan tentang potensi risiko yang terlibat dengan teknologi yang berkuasa dan semakin popular ini, yang mampu menjana kandungan dengan pantas dan menyelesaikan tugas berdasarkan algoritma yang direka untuk meniru kecerdasan seseorang.

“Pengalaman manusia adalah tentang bercerita, dan di sini anda mempunyai alat bercerita yang merupakan jenis alat baharu,” kata Shelly Palmer, seorang profesor media lanjutan di Syracuse University dan perunding pengiklanan, pemasaran dan teknologi.

“Ia menceritakan kisah interaktif yang agak menarik dan jelas ia mengasyikkan,” kata Palmer. “Teknologi ini tidak bukan bahaya. Kita berada di dunia baru. Dan kami tidak pernah ke sini sebelum ini.”

Jangan sekali-kali terlepas cerita — daftarlah untuk surat berita harian percuma PEOPLE untuk mengikuti perkembangan terbaik tentang apa yang PEOPLE tawarkan, daripada berita selebriti hingga kisah menarik minat manusia.

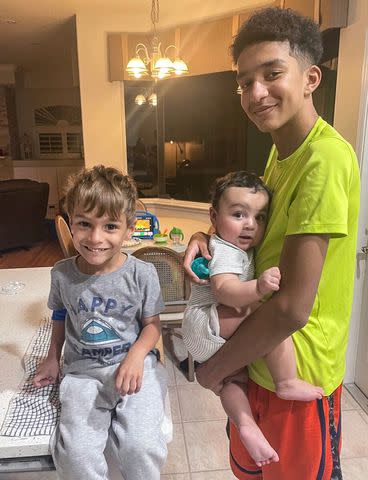

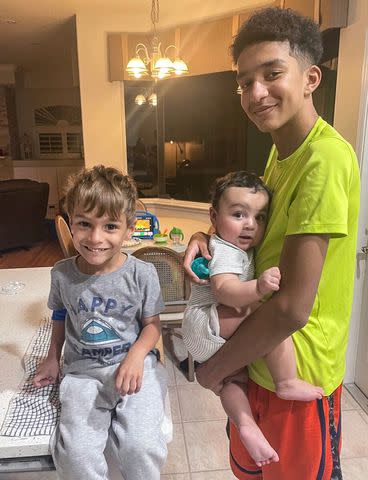

Dengan hormat Megan Garcia

Sewell Setzer III (kanan) bersama dua adik lelakinya, Alexander dan Gabriel, pada 2022.

Pada saat-saat terakhirnya sebelum mati menembak dirinya sendiri di bilik mandinya, pada bulan Februari, Sewell telah menghantar mesej dengan bot Daenerys Targaryen.

“Saya sangat sayangkan awak, Dany,” dia menulis beberapa saat sebelum menarik picu pada pistol bapa tirinya di rumah keluarganya di Orlando, Fla.

“Bagaimana jika saya beritahu awak saya boleh pulang sekarang?” dia menulis.

Bot itu menjawab, “…tolong lakukan, raja manisku.”

Bagi Palmer, kematian Sewell menjadi contoh lain bahawa internet dan segala-galanya pada dasarnya adalah alat yang perlu difahami dan diambil serius.

“Saya sangat sakit hati kerana sebagai seorang manusia, bapa dan datuk,” katanya mengenai kematian budak itu. “Sebagai seorang ahli teknologi yang menghabiskan banyak masa dengan alat ini, kita sebagai masyarakat perlu memahami bahawa semua internet dan semua teknologi memerlukan pengawasan. Ini bukan mainan, dan mungkin ia perlu disertakan dengan label amaran.”

Tuntutan kematian salah 152 halaman Garcia terhadap Character.AI mendakwa bahawa teknologi syarikat itu “cacat dan/atau sememangnya berbahaya.” Saman itu memperincikan bagaimana kesihatan mental Sewell merosot selama 10 bulan sebelum kematiannya kerana dia sering menghantar mesej teks dengan chatbot berpuluh-puluh kali sehari.

Berkaitan: Mengapa Keluarga Berduka Didedahkan Dengan Ketagihan Remaja terhadap AI Bot, Yang Mereka Salahkan Kerana Bunuh Dirinya (Eksklusif)

Eva Marie Uzcategui/Bloomberg melalui Getty

Shelly Palmer

“Defendan berusaha keras untuk membuat kejuruteraan [his] kebergantungan yang berbahaya pada produk mereka, menderanya secara seksual dan emosi,” dakwa aduan Garcia, “dan akhirnya gagal menawarkan bantuan atau memberitahu ibu bapanya apabila dia menyatakan idea untuk membunuh diri.”

Pakar dan pemerhati berkata ia masih sangat tidak jelas, pada peringkat awal ini, bagaimana sebenarnya syarikat teknologi dan masyarakat harus mengehadkan sebarang potensi risiko daripada alatan AI yang semakin ramai orang beralih kepada – bukan hanya untuk bekerja tetapi untuk bersosial di tengah-tengah wabak yang dilaporkan. kesunyian.

“Apa yang saya akan katakan ialah anda perlu meneruskan dengan mata terbuka dengan berhati-hati,” jelas Shelly. “Kita akan belajar [the best way to use it] sebagai masyarakat. Tetapi kami masih belum belajar cara menggunakan media sosial.”

Dia meneruskan: “Berapa lama masa yang diperlukan untuk kita belajar cara menggunakan AI generatif dalam chatbot perbualan? Seperti yang saya katakan, kita sudah 20 tahun menggunakan media sosial dan kita masih memikirkannya.”

Memandangkan AI semakin terjalin dalam kehidupan seharian, Palmer berkata adalah penting bagi kita semua untuk mula mengambil pendekatan yang lebih skeptikal setiap kali kita menghadapi teknologi ini. Character.AI telah berkata kira-kira 20 juta orang berinteraksi dengan bot “superintelligent” setiap bulan.

“Saya fikir apa yang benar-benar penting untuk difahami oleh semua orang ialah teknologi kini berada pada titik di mana kita berkongsi planet dengan kecerdasan yang dipisahkan daripada kesedaran,” kata profesor itu. “Dan kerana itu, menjadi tanggungjawab kita untuk lalai untuk tidak percaya apabila kita menghadapi apa-apa yang dijana oleh teknologi kerana anda tidak tahu apa itu.”

Berkaitan: Remaja, 14, Mati Bunuh Diri Selepas Jatuh 'Cinta' dengan AI Chatbot. Kini Ibunya Menyaman

Ketidakpercayaan, jelas Palmer, bertentangan dengan bagaimana manusia telah berkembang sepanjang suku juta tahun yang lalu.

“Ia bukan sifat manusia,” katanya. “Kami berwayar untuk lalai kepada idea bahawa 'Saya akan mempercayai anda sehingga anda membuktikan kepada saya bahawa saya tidak sepatutnya.'”

Tetapi apabila manusia berinteraksi dengan “kandungan yang dicipta oleh orang yang anda tidak kenali, dengan cara yang anda tidak faham, dengan perkara yang anda tidak semestinya mengawal,” ketidakpercayaan adalah pendekatan paling selamat, katanya.

Jika tidak ada yang lain, tambah Shelly, liputan media mengenai tuntutan Garcia memaksa orang ramai untuk mula berfikir dengan lebih kritis tentang isu chatbots AI.

“Saya rasa adalah penting untuk tuntutan mahkamah ini dibawa,” katanya. “Sama ada mereka berjaya atau tidak tidak akan mengembalikan anaknya. Tetapi apa yang boleh dilakukannya ialah menyelamatkan ramai anak lelaki orang lain.”

Jika anda atau seseorang yang anda kenali sedang mempertimbangkan untuk membunuh diri, sila hubungi Talian Hayat Pencegahan Bunuh Diri Kebangsaan di 1-800-273-TALK (8255), hantarkan “STRENGTH” ke Talian Teks Krisis di 741-741 atau pergi ke suicidepreventionlifeline.org.